Attribuzione degli attacchi APT a Stati-Nazione: metodologie di indagine e false-flag

Attribuire un attacco condotto da APT a un attore specifico (spesso una nazione) è un processo complicato e integra tecnica e contesto geopolitico. Non basta analizzare i malware e i log, è necessario considerare anche gli interessi strategici e gli indizi indiretti.

Ci sono sei aree chiave utilizzare per attribuire attacchi APT, inoltre ci sono tecniche di depistaggio ormai ben documentate.

indicatori geopolitici e di contesto

Un elemento cruciale nell’attribuzione è il contesto geopolitico. Bisogna valutare come motivi e tempistica di un attacco si inseriscono in tensioni politiche, conflitti militari o interessi economici di un determinato paese. In pratica, l’attribuzione avviene su più livelli: dal tattico (indicatori tecnici come IP e malware) allo strategico, che considera gli obiettivi e i mandanti dell’attacco.

- Allineamento con interessi nazionali: Spesso i bersagli di un APT riflettono le priorità strategiche di uno Stato. Ad esempio, Mandiant ha rivelato che gli attacchi di APT1 (collegato all’Esercito Popolare di Liberazione cinese) erano rivolti a industrie che la Cina aveva dichiarato settori strategici per la propria crescita, coincidenti con quelli del 12º Piano Quinquennale cinese. In altre parole, le vittime appartenevano a settori (tecnologia, energia, telecomunicazioni, ecc.) di diretto interesse per Pechino, un indizio forte sul mandante.

- Conflitti militari e attacchi informatici: Nel contesto della guerra ibrida, gli attacchi APT spesso accompagnano o precedono le operazioni militari tradizionali. Un caso è la serie di attacchi contro l’Ucraina in concomitanza con il conflitto con la Russia. Il blackout elettrico in Ucraina del dicembre 2015 – il primo attacco informatico riuscito a una rete elettrica – è stato attribuito al gruppo russo Sandworm, collegato all’intelligence militare russa (GRU). Allo stesso modo, il malware NotPetya del 2017, diffuso inizialmente in Ucraina, si è rivelato un attacco distruttivo su larga scala orchestrato dalla Russia, mascherato da ransomware (ne riparleremo più avanti). Questi attacchi combaciano con gli interessi strategici russi nel contesto del conflitto, rafforzando l’attribuzione agli attori statali russi.

- Tensioni regionali e cyberspionaggio: Le rivalità geopolitiche regionali spesso si riflettono nel cyberspazio. Ad esempio, la Cina è ritenuta responsabile di campagne di intrusione contro istituzioni governative e aziende di Taiwan, soprattutto in momenti di tensione politica, coerentemente con l’interesse di Pechino a raccogliere intelligence sull’isola. Allo stesso modo, gruppi attribuiti all’Iran (es. APT33) hanno colpito settori energetici sauditi in periodi di scontro politico, mentre gruppi nordcoreani (es. Lazarus) hanno attaccato enti finanziari internazionali quando le sanzioni economiche verso Pyongyang si inasprivano. In tutti questi casi l’analisi del “movente” fornisce utili indizi di attribuzione.

Va sottolineato che gli indicatori geopolitici da soli non costituiscono “prove” definitive. Tuttavia, combinati con evidenze digitali, rafforzano la confidenza di una attribuzione. Per esempio, se un attacco colpisce sistematicamente agenzie governative NATO e organizzazioni favorevoli a una certa causa contraria agli interessi russi, ciò suggerisce fortemente un’iniziativa russa. CrowdStrike ha documentato che il gruppo APT28 (Fancy Bear) – ritenuto unità del GRU russo – ha preso di mira enti militari e politici in Europa e NATO in linea con la politica estera russa. L’integrazione di elementi politici, storici e militari è parte integrante dei modelli di attribution: il contesto aiuta a collegare i puntini che i soli dati tecnici lascerebbero sconnessi.

2. Analisi linguistica nei binari e nei documenti

Ogni programmatore o redattore lascia tracce linguistiche nel proprio lavoro – dal codice sorgente ai documenti di phishing – e queste tracce possono rivelare la lingua madre o la provenienza culturale degli autori di un attacco APT. Gli analisti di cyber threat intelligence conducono spesso un’analisi linguistica su vari elementi:

- Stringhe di testo nei malware: Commenti nel codice, messaggi di errore, nomi di variabili e funzioni possono contenere idiomi o abbreviazioni proprie di una certa lingua. Ad esempio, Flashpoint ha scoperto che le note di riscatto del ransomware WannaCry (che colpì a livello globale nel 2017) furono redatte inizialmente in cinese mandarino fluente, mentre le versioni in inglese apparivano tradotte automaticamente. Ciò ha suggerito che almeno uno degli autori fosse sinofono, pur essendo WannaCry generalmente attribuito alla Corea del Nord (gruppo Lazarus). Allo stesso modo, molti malware di APT28 contenevano stringhe in cirillico o impostazioni di lingua russa, in linea con un team di sviluppo russo.

- Stile e grammatica di documenti e email: Le campagne APT spesso iniziano con email di spear phishing o documenti malevoli. Analizzare errori grammaticali sistematici o scelte lessicali può far emergere l’influenza di una lingua nativa. Ad esempio, frasi costruite con strutture tipiche del cinese o errori commessi da parlanti russi che scrivono in inglese forniscono indizi sulla nazionalità degli autori. Anche l’uso di determinati formati di documenti può essere rivelatore: il gruppo nordcoreano Lazarus prediligeva l’uso di documenti Hangul (il software sudcoreano) nelle sue operazioni, indicativo di una familiarità con la lingua/corea.

- Linguaggio di programmazione e toolchain: Alcuni attori preferiscono ambienti e linguaggi specifici. Ad esempio, un gruppo cinese potrebbe preferire tool in linguaggio Delphi (storicamente diffuso in Cina per software gestionali), mentre attori occidentali usano più spesso .NET o PowerShell. Queste preferenze, combinate con altri indizi, possono aiutare il puzzle attributivo.

Ma è bene sapere che bisogna considerare le tecniche di falsificazione del linguaggio impiegate dai threat actor più sofisticati. Così come un criminale può indossare abiti o accenti per confondere le indagini, un hacker può intenzionalmente inserire tracce linguistiche fuorvianti – è il concetto di linguistic obfuscation.

Un caso emblematico è emerso dai leak di WikiLeaks Vault 7 sulla CIA: il progetto Marble Framework era pensato proprio per offuscare gli indizi linguistici nei malware dell’intelligence americana inserendo stringhe in lingue straniere per depistare gli analisti. Marble poteva far sembrare un malware americano come se fosse stato scritto da programmatori cinesi o russi, aggiungendo e poi “nascondendo” deliberatamente pezzi di codice con commenti in altre lingue. Questo permette un “gioco forense a doppio livello” in cui gli investigatori trovano quelle che credono essere tracce evidenti senza rendersi conto di essere stati attirati verso una conclusione sbagliata.

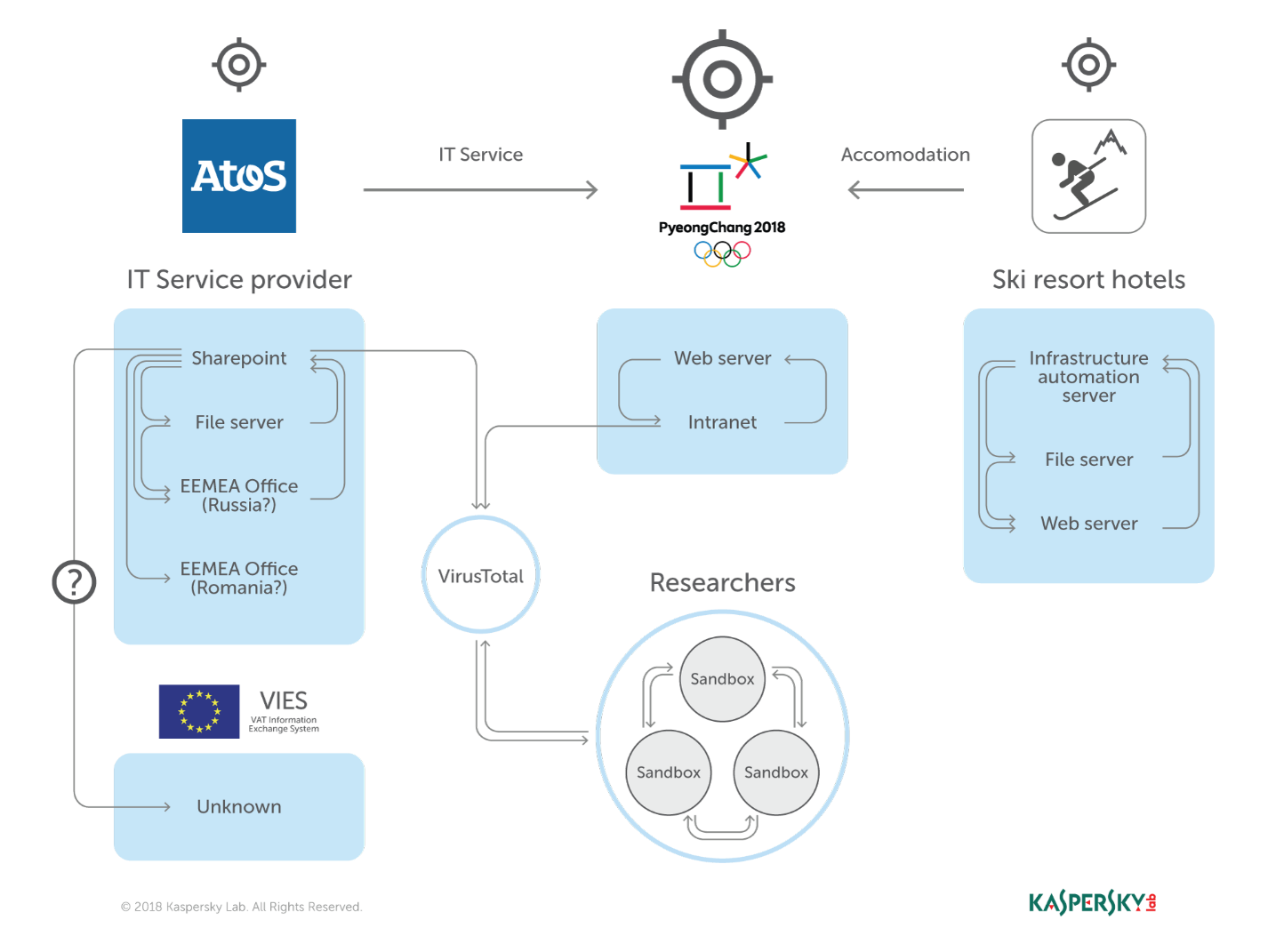

Un esempio studiato di false flag linguistico si è avuto con il malware OlympicDestroyer (attacco alle Olimpiadi invernali 2018): inizialmente conteneva byte che facevano pensare a un autore nordcoreano (richiamando il codice del gruppo Lazarus), ma si scoprì poi che erano stati inseriti ad arte dai veri autori (russi) per ingannare l'analisi post-mortem. L’analisi linguistica è un’arma a doppio taglio: fornisce preziosi insight – come “il codice contiene commenti in mandarino” (esempio: pagine di phishing con commenti JavaScript in cinese semplificato indicano uno sviluppatore sinofono) – ma questi indizi possono essere manipolati. Gli analisti dunque incrociano sempre i dati linguistici con altre prove onde evitare di cadere vittima di depistaggi linguistici.

3. Timestamp e fusi orari

Ogni file eseguibile, registro di sistema o server log porta con sé informazioni temporali – orari di compilazione, di accesso, di utilizzo – che possono svelare il fuso orario e quindi la possibile provenienza geografica degli aggressori. Gli investigatori eseguono la cd time zone analysis, ossia l’analisi degli orari in cui si sono verificate le attività malevole, per inferire in che fascia oraria opera il gruppo APT.

Come funziona questo approccio? Si raccolgono gli orari (timestamp) degli eventi chiave legati all’attacco: quando il malware è stato compilato, a che ora il server di Command and Control viene contattato, gli orari dei file creati o modificati sui sistemi vittima, ecc. Questi orari, convertiti in un fuso orario comune (di solito UTC), vengono poi confrontati con gli orari locali di varie zone geopolitiche. Se si nota che la maggior parte delle attività di un hacker avviene tra le 9:00 e le 17:00 UTC+8, ciò suggerisce un team che lavora dall’Asia orientale (fuso orario di Pechino) durante orari d’ufficio. FireEye evidenziò proprio questo nel 2014: il gruppo russo APT28 compilava quasi tutto il suo malware durante la giornata lavorativa dell’orario di Mosca (UTC+3/UTC+4) – l’88% dei campioni era compilato tra le 8:00 e le 18:00 (lun–ven), coerentemente con la settimana lavorativa russa. Inoltre, il sistema su cui compilavano aveva impostazioni di lingua in russo, rafforzando l’ipotesi di un team localizzato in Russia.

Allo stesso modo, Mandiant nel caso APT1 (gruppo cinese) notò che in 97% delle sessioni Remote Desktop osservate gli aggressori avevano il sistema operativo configurato in lingua cinese semplificata e utilizzavano tastiere con layout cinese. Incrociando questi dati con gli orari di accesso (spesso in orario diurno di Pechino), si poté affermare con una certa sicurezza che l'operazione era sponsorizzata dalla Cina.

Naturalmente, l’analisi dei timestamp richiede alcune precauzioni tecniche: bisogna normalizzare gli orari (convertirli tutti in un unico riferimento temporale), tener conto dell’ora legale, e soprattutto distinguere l’orario locale della vittima da quello dell’attaccante. Ad esempio, un malware può avere nel suo header PE un orario di compilazione; se il PC dell’attaccante era impostato su fuso orario GMT+3, quel dato rimane nell’eseguibile. Aggregando decine di orari di compilazione di malware di un dato gruppo, si può spesso vedere un pattern (es. nessuna compilazione tra le 18 e le 8 GMT+3, cioè il team “stacca” la sera). Questi pattern temporali sono indizi circumstantiali forti sull’origine geografica.

Ovviamente, come ogni evidenza indiretta, anche i timestamp possono essere alterati. Un attore scaltro potrebbe compilare i malware su una macchina impostata a UTC o addirittura sul fuso orario di un altro paese per confondere le acque. Oppure pianificare operazioni fuori dal proprio orario normale simulando un diverso fuso (vedremo nel prossimo punto). In più, non bisogna dimenticare che alcuni dati temporali possono derivare dai sistemi delle vittime (ad esempio l’orario di creazione di un file su un server bersaglio riflette l’orologio di quel server, non dell’hacker). Quindi gli analisti devono selezionare con cura quali timestamp riflettono l’ambiente degli aggressori. In generale quando avvengono le attività è un tassello importante: l’analisi dei fusi orari può indicare l’origine probabile degli attori, ma resta un’evidenza indiretta facilmente falsificabile. Quasi nessun gruppo APT può lavorare 24 ore su 24; le impronte temporali che lasciano rivelano spesso il loro “orario d’ufficio”.

4. Attività legata a orari lavorativi

Strettamente collegato all’analisi dei fusi orari è lo studio dei pattern di attività degli attaccanti, ovvero la distribuzione degli attacchi nel tempo: giorni della settimana, ore del giorno, eventuali pause ricorrenti. Gli analisti cercano di capire se gli hacker seguono una routine “da ufficio”, suggerendo che si tratti di personale stipendiato che lavora a orari regolari, presumibilmente per un governo o un’organizzazione militare.

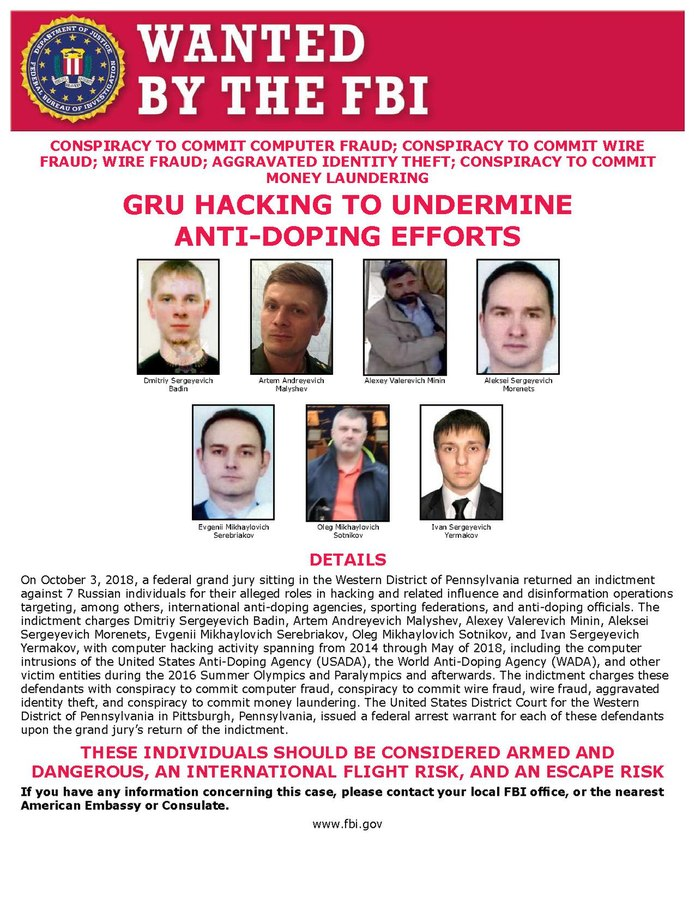

Un elemento spesso citato è la assenza di attività nei fine settimana o festivi: mentre criminali comuni o hacker “solitari” potrebbero operare a qualunque ora, vari gruppi APT attribuiti a Stati mostrano sorprendente disciplina lavorativa. Ad esempio, l’analisi di FireEye su APT28 (Russia) rivelò che il 97% dei malware di questo gruppo veniva compilato dal lunedì al venerdì, orari 8-18, con pochissime compilazioni nel weekend (orario di Mosca). Ciò coincide con l’idea che APT28 sia un team di professionisti con orari d’ufficio. Ancora più curioso, durante l’operazione di hacking al Comitato Democratico USA nel 2016, gli analisti notarono che gli hacker (Fancy Bear/APT28) non effettuarono attività il 15 aprile 2016, data corrispondente a una festività in Russia (giorno dedicato alle unità di guerra elettronica). Questa pausa precisa – inspiegabile per un gruppo criminale qualsiasi – è altamente indicativa: suggerisce che il team seguiva il calendario lavorativo russo, rafforzando l’attribuzione al GRU russo.

Un altro esempio: gruppi cinesi spesso mostrano riduzione di attività durante il periodo del Capodanno Lunare, mentre gruppi iraniani possono diminuire le operazioni durante il Nowruz (Capodanno persiano). Tali correlazioni sono state riportate in diverse analisi di threat intelligence e aiutano a “dare un volto” agli attaccanti.

Pattern di esfiltrazione dati: Alcuni APT programmano il furto e il trasferimento di dati in orari specifici. Ad esempio, se si nota che da una rete vittima i dati fluiscono verso l’esterno sempre tra le 17 e le 19 ora locale di Pechino, potrebbe indicare che gli operatori cinesi raccolgono file durante la giornata e li estraggono prima di terminare il turno lavorativo. Viceversa, in altri casi gli attaccanti scelgono orari notturni della vittima (quando gli uffici bersaglio sono chiusi) per esfiltrare informazioni senza essere scoperti, il che però potrebbe coincidere con la mattina del proprio fuso orario. Ad esempio, un gruppo europeo che attacca infrastrutture USA potrebbe agire di notte (USA) corrispondente alla mattina in Europa. Incrociando questi dati, si può delineare un profilo di orario di lavoro degli aggressori.

Gli analisti tengono d’occhio anche la costanza sul lungo termine: un gruppo APT impiegato stabilmente da un governo manterrà abitudini prevedibili mese dopo mese, mentre un collettivo hacktivista o criminale potrebbe essere più erratico. Se per sei mesi si osserva che gli incidenti attribuiti a un certo gruppo avvengono solo tra lunedì e venerdì e mai tra le 1:00 e le 5:00 del mattino del loro fuso orario, è lecito pensare che quegli hacker timbrino il cartellino.

Naturalmente, gli attori più evoluti possono tentare di simulare fusi orari diversi o rompere i propri schemi operativi per ingannare. Ad esempio, il gruppo russo Turla (APT noto) in alcune operazioni ha condotto attività anche di sabato o domenica, forse nel tentativo di non apparire “troppo russo” agli occhi degli analisti. Oppure potrebbero orchestrare una piccola percentuale di attacchi in orari atipici così da sporcare il pattern. Nonostante ciò, mantenere a lungo una falsa routine è dispendioso e difficile. Molto spesso i gruppi ricadono nei propri ritmi naturali, offrendo così agli investigatori attenti un prezioso indizio temporale sulla loro identità nazionale.

In sintesi, l’attività legata a orari lavorativi completa l’analisi dei fusi orari con una dimensione comportamentale: quando lavorano gli hacker. Un gruppo sponsorizzato da uno Stato tenderà ad operare come un reparto aziendale (orari regolari, festività rispettate, magari cambi turno prevedibili), mentre attori non statali avranno schemi meno regolari. Questa informazione, unita ad altri indicatori, aumenta la confidenza nell’attribuzione – tenendo sempre presente che un avversario scaltro potrebbe cercare di mascherare i propri orari, anche se ciò richiede un livello di disciplina operativa non comune.

5. Tecniche di false flag e depistaggio

Man mano che le capacità di attribuzione sono migliorate, gli attori statuali più avanzati hanno sviluppato tecniche di false flag per confondere analisti e investigatori. L’obiettivo è inserire tracce ingannevoli che puntino verso altri gruppi o nazioni, sviando le accuse (o addirittura causando attribuzioni errate verso un avversario, innescando conflitti diplomatici). Esistono diversi livelli e metodi di depistaggio documentati:

- Falsi indicatori linguistici o culturali: Come visto, possono inserire deliberatamente stringhe in lingue straniere. Olympic Destroyer ne è un caso celebre: gli autori (presumibilmente russi) incorporarono nel malware frammenti di codice simili a quelli usati dal gruppo nordcoreano Lazarus, per simulare la loro “firma digitale”. Kaspersky definì quello di OlympicDestroyer un “false flag molto sofisticato”, progettato per far credere agli analisti di aver trovato la “pistola fumante” – quando invece era un’incriminazione costruita ad arte. Solo un’analisi approfondita rivelò l’inganno, evitando una clamorosa attribuzione al bersaglio sbagliato.

- Uso di infrastruttura e identità altrui: Un approccio ancor più insidioso è rubare o imitare gli strumenti di un altro gruppo. Nel 2019 emerse che il gruppo russo Turla aveva di fatto dirottato l’infrastruttura di comando&controllo e alcuni malware di un gruppo iraniano (APT34/OilRig) per condurre attacchi sotto copertura. In pratica i russi hanno “hackerato gli hacker” iraniani: utilizzando i server e i programmi dell’APT34, gli attacchi sembravano provenire da quest’ultimo. È un livello di false flag molto avanzato, perché anche scoprendo i server e i malware, si sarebbe attribuita la campagna all’Iran, mentre il vero burattinaio era altrove. Solo la collaborazione d'intelligence tra NSA e NCSC (UK) ha permesso di svelare che dietro quelle attività apparentemente iraniane c’era la mano russa.

- “Code borrowing” e tool repackaging: Spesso i gruppi APT utilizzano strumenti pubblici o trapelati da altri attori. Dopo la divulgazione di exploit NSA (es. EternalBlue), questi sono stati usati sia da gruppi nordcoreani che russi, rendendo difficile capire chi stesse agendo. Alcuni attaccanti invece di sviluppare un malware proprietario (che potrebbe essere tracciabile), riutilizzano malware esistenti di altri. Ad esempio, se un gruppo di criminali usa abitualmente un trojan (disponibile nel dark web), un APT statale potrebbe usarne una variante per far ricadere sospetti sulla criminalità comune. Un altro caso: si ritiene che il gruppo russo Fancy Bear abbia talvolta riutilizzato varianti del malware BlackEnergy (precedentemente associato ad attori diversi) per seminare confusione. Questa pratica di repackaging di tool noti complica l’attribuzione: gli indicatori tecnici da soli possono portare fuori strada se non si considera il contesto.

- Falsi rivendicazioni e personaggi fittizi: Sul fronte più “psicologico”, ci sono attacchi in cui gli autori creano una falsa identità rivendicando l’azione. Un esempio è l’attacco del 2015 alla TV5Monde in Francia: inizialmente comparve un gruppo chiamato “CyberCaliphate” che sosteneva di agire per conto dell’ISIS, pubblicando messaggi jihadisti. La Francia scoprì in seguito che si trattava di un false flag e che l’attacco distruttivo era opera di hacker russi (APT28) mascheratisi da cellule dell’ISIS. Creare un alias fittizio (come Guccifer 2.0 nel caso DNC 2016, dietro cui si celava sempre Fancy Bear) è una tattica per deviare l’attenzione o politicizzare diversamente l’evento.

Questi tentativi di depistaggio possono essere più o meno sofisticati. A livelli più bassi c’è il semplice “lasciare tracce spurie” (es. usare un indirizzo IP di un paese terzo tramite VPN, o impostare la lingua del PC su spagnolo). A livelli intermedi c’è il riuso ragionato di malware e infrastrutture altrui. Al top c’è la masquerade completa, in cui un attore penetra l’operatività di un altro (come Turla vs OilRig) o combina più false flag insieme (come OlympicDestroyer che ha mescolato pezzi di codice di almeno 2-3 attori differenti). Va notato che queste operazioni di depistaggio richiedono risorse e pianificazione, e non sempre gli attaccanti le implementano correttamente. Gli investigatori addestrati, incrociando molteplici indizi, possono spesso smascherare i false flag: ad esempio, sebbene OlympicDestroyer avesse indizi nordcoreani, altre caratteristiche (vittime colpite, tempistica, tecniche note) puntavano verso la Russia, spingendo alcuni ricercatori a guardare più a fondo e scoprire l’inganno.

Per questi motivi le aziende di sicurezza e le agenzie (Mandiant, CrowdStrike, Kaspersky, NSA, etc.) si affidano a modelli di attribuzione multilivello e a team interdisciplinari (esperti di lingua, intelligence geopolitica, analisti malware) per riconoscere i depistaggi. L’attribuzione, quindi, non è mai basata su un singolo indicatore isolato, soprattutto sapendo che quell’indicatore potrebbe essere manipolato intenzionalmente.

6. Margini di errore e controversie nell’attribuzione

Nonostante i progressi nelle tecniche investigative, l’attribuzione di attacchi cyber rimane in parte un’arte imperfetta, soggetta a margini di errore, zone grigie e talvolta a dispute accese. Ci sono limiti strutturali e variabili umane da considerare:

- Condivisione di strumenti e tattiche: Come sottolineato dall’esperto Bruce Schneier, nel cyberspazio “tutti usano le stesse armi”. Hacker governativi, criminali, hacktivisti – sfruttano spesso le stesse vulnerabilità, strumenti simili e tattiche comuni, lasciando tracce tecniche indistinguibili. A differenza di un missile o un carro armato (che porta matricole e provenienza chiara), un malware o una botnet può essere usato da chiunque. Ciò significa che identificare l’attore dietro un attacco richiede inferenze: chi poteva avere l’intento? Chi aveva l’accesso a quel tool in quel momento? Si entra nel campo della probabilità più che della certezza assoluta.

- Bias e interpretazioni soggettive: Gli analisti, per quanto esperti, possono essere influenzati da bias cognitivi o pressioni politiche. Un’indagine condotta in un contesto di tensione internazionale potrebbe essere portata a cercare conferme di colpevolezza di un certo attore. Allo stesso modo, un indicatore linguistico o comportamentale potrebbe essere mal interpretato per mancanza di conoscenza del contesto culturale: ad esempio, un proverbio russo mal tradotto in un phishing email potrebbe passare inosservato a chi non conosce la cultura russa. Bias politici: governi e aziende di cybersecurity occidentali possono avere maggior familiarità (e focalizzazione) con le minacce di Russia, Cina, Iran, Corea del Nord, e meno con altri, potenzialmente portando a squilibri nell’attenzione attribuitiva. All’opposto, paesi accusati possono gridare al bias per delegittimare le accuse (la Cina e la Russia regolarmente definiscono “prive di prove” le imputazioni rivoltegli, insinuando un pregiudizio politico).

- Limiti delle prove tecniche: Raramente si ottiene la smoking gun in questi contesti. Le prove definitive – es. identificare un individuo specifico dietro una tastiera – di solito sono frutto di operazioni di intelligence classica (humint, intercettazioni) più che dell’analisi tecnica. Quest’ultima fornisce un insieme di indizi. Ma come in un tribunale, tanti indizi fanno una prova solo se coerenti e non spiegabili diversamente. A volte però gli indizi sono contraddittori. Un esempio famoso di controversia fu l’attacco a Sony Pictures (2014). L’FBI puntò subito il dito verso la Corea del Nord, citando similitudini di malware e IP noti di Lazarus. Alcuni esperti indipendenti all’epoca sollevarono dubbi: notavano che il malware wiper usato (Destover) era reperibile online e che l’attacco sembrava quasi troppo “palese” (perché avrebbe dovuto firmarsi Guardians of Peace e minacciare Sony in stile terrorista?). Ricercatori come Marc Rogers ipotizzarono persino un possibile insider o criminali comuni, non trovando sufficienti elementi univoci per attribuirlo a Pyongyang. Schneier scrisse nel 2015 “ancora non sappiamo chi ha hackerato Sony”, evidenziando come controindicazioni e piste alternative (Russia, vendetta di dipendenti) non potessero essere completamente escluse. Col tempo, il consenso si è formato sulla responsabilità nordcoreana (anche grazie a informazioni di intelligence e poi a incriminazioni formali del DOJ USA), anche per il contesto (attacco rivolto a scoraggiare un film satirico sul regime nordcoreano), lasciando comunque zone d’ombra nella certezza assoluta.

Anche il caso NotPetya (2017) è istruttivo: all’inizio fu etichettato come un attacco ransomware legato a Petya, ma si scoprì presto che il malware non permetteva affatto di recuperare i dati, comportandosi invece da puro strumento distruttivo (un wiper travestito da ransomware). L’analisi tecnica lo collegò a sviluppatori già noti (con codice e TTP affini al gruppo Sandworm russo) ed emerse che l’operazione era probabilmente volta a colpire l’Ucraina sotto copertura di un attacco criminale. Nel febbraio 2018, infatti, diverse nazioni (USA, UK, etc.) hanno pubblicamente attribuito NotPetya all’intelligence militare russa. Ovviamente la Russia negò ufficialmente ogni coinvolgimento, e inizialmente la somiglianza con un comune ransomware aveva tratto in inganno molti. Questo caso evidenzia sia la raffinatezza nei false flag (usare un malware apparentemente a scopo di lucro per un sabotaggio statale), sia la necessità di prudenza nelle fasi iniziali di analisi: un attacco può venire interpretato erroneamente (cyber-crimine vs cyber-war) e l’attribuzione definitiva può emergere solo dopo approfondite verifiche incrociate.

Le migliori pratiche oggi prevedono di corroborare ogni indizio con altri: un’indicazione di fuso orario (timestamp) diventa rilevante solo se supportata da riscontri linguistici e da un movente geopolitico credibile, riducendo il peso di possibili false flag. L’attribuzione non è mai matematica: si parla in termini di alta confidenza, stime probabilistiche e talvolta si esplicita un margine di incertezza. Come nota un recente survey accademico, il processo di attribuzione richiede trasparenza e spiegazioni chiare del perché si punta il dito su un attore. Nonostante i limiti, l’attribuzione resta fondamentale per chiamare alle responsabilità gli aggressori statali, informare difese strategiche e anche delineare norme di comportamento accettabile nel cyberspazio.